ω(オメガ)係数は内的整合性を確認するための指標である。近年はCronbachのαより良い方法と言われることが多い。Cronbachのαは因子構造を無視して、一次元性の検証していることが原因である。

データ

psychパッケージに含まれるIPIP-NEOのデータbfiを使用する。

このエントリでは、確証的因子分析で5因子構造のω係数の計算をする。

bfiの説明はこちら ides.hatenablog.com

library("psych")

data <- bfi[1:25]

計算

計算はsemToolsパッケージを利用する。

library(lavaan)

library(semTools)

model <- ' Agreeableness =~ A1 + A2 + A3 + A4 + A5

Conscientiousness =~ C1 + C2 + C3 + C4 + C5

Extraversion =~ E1 + E2 + E3 + E4 + E5

Neuroticism =~ N1 + N2 + N3 + N4 + N5

Openness =~ O1 + O2 + O3 + O4 + O5'

fit <- cfa(model, data = data, std.lv=T)

reliability(fit)

結果

Agreeableness Conscientiousness Extraversion Neuroticism Openness alpha 0.4437533 -0.316283414 -0.65524296 0.8169469 -0.17609811 omega 0.5912043 0.005802957 0.04766026 0.8179816 0.04241799 omega2 0.5912043 0.005802957 0.04766026 0.8179816 0.04241799 omega3 0.6061009 0.004594535 0.04553222 0.8082328 0.03816464 avevar 0.3502353 0.371791388 0.40308320 0.4808678 0.24482561

5種類の出力がされる。

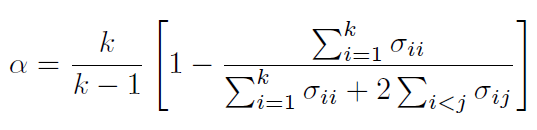

Cronbach's alpha

alphaはクロンバッハのαである。

Cronbach, L. J. (1951). Coefficient alpha and the internal structure of tests. Psychometrika, 16(3), 297–334. https://link.springer.com/article/10.1007/BF02310555

Raykov's omega

omegaとあるのはRaykov's omegaである。

Raykov, T. (2001). Estimation of congeneric scale reliability using covariance structure analysis with nonlinear constraints British Journal of Mathematical and Statistical Psychology, 54(2), 315-323. https://onlinelibrary.wiley.com/doi/abs/10.1348/000711001159582

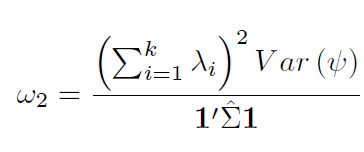

bentler's omega

omega2はbentler's omegaである。

Bentler, P. M. (2009). Alpha, dimension-free, and model-based internal consistency reliability.Psychometrika, 74(1), 137–143. https://link.springer.com/article/10.1007/s11336-008-9100-1

McDonald's omega(1999)

omega3はMcDonald's omegaである。

Test Theory: A Unified Treatment (English Edition)

- 作者:McDonald, Roderick P.

- 発売日: 2013/06/17

- メディア: Kindle版

注意が必要なのはMcDonald's omegaというと1978年の論文があるが、1978年と1999年のものは違うものだということである。

Roderick P. McDonald(1979). Generalizability in Factorable Domains: "Domain Validity and Generalizability" Educational and Psychological Measurement, 38(1), 75-79. https://journals.sagepub.com/doi/abs/10.1177/001316447803800111

平均分散抽出

avevarは平均分散抽出average variance extracted (AVE)である。