評価者が3人以上、評価項目が名義尺度で3カテゴリ以上で利用される一致度の指標である。有名なCohen's Kappa(κ) の拡張版である。

Light’s Kappa

評価者が2人以上、2つ以上のカテゴリカル変数で使用する一致度の指標である。

RのirrパッケージでLight’s Kappaを計算する

irrパッケージで計算ができる。

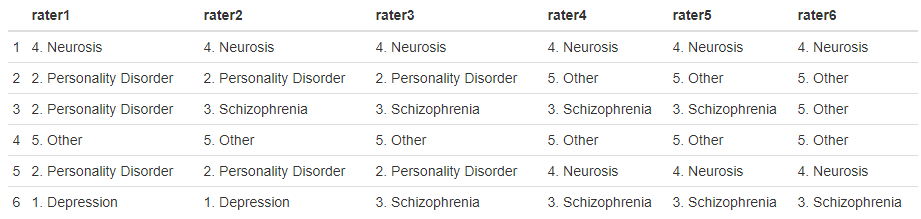

diagnosesデータを利用する。データ構造は下記のようになってている。

評価者がraterで、6人の評価者がいるデータである。

精神疾患の評価がされているが、1.Depression、2. Personality Disorder、3. Schizophrenia、4. Neurosis、5. Otherの5つが評価されている。

評価されているものは、順序尺度や間隔尺度ではなく、名義尺度である。Light’s Kappaを利用するのは、評価者が2人以上(特に3人以上)、評価項目が名義尺度で2カテゴリ(特に3カテゴリ以上)ということだ。

library(irr) data(diagnoses) kappam.light(diagnoses)

Kappaは0.459であった。

Subjects = 30

Raters = 6

Kappa = 0.459

z = 2.31

p-value = 0.0211

- Light, R.J. (1971). Measures of response agreement for qualitative data: Some generalizations and alternatives. Psychological Bulletin, 76, 365-377.

Fleiss' kappa

評価者が2人以上、2つ以上のカテゴリカル変数で使用する一致度の指標である。Light’s Kappaのと同じ条件で使うものである。

irrパッケージでの計算

kappam.fleiss(diagnoses)

結果。

Subjects = 30

Raters = 6

Kappa = 0.43

z = 17.7

p-value = 0

評価者を指定するコマンドもあるらしい。こちらは1-4の評価者だけ計算するコード。

kappam.fleiss(diagnoses[,1:4])

- Fleiss, J. L. (1971) "Measuring nominal scale agreement among many raters." Psychological Bulletin, Vol. 76, No. 5 pp. 378–382

Exact Kappa

Fleiss (1971)のKappa係数は2人の評価者ではCohen's Kappa(重みづけをせず)にはならない。その修正がConger(1980)によってされたのがexact Kappa係数である。

kappam.fleiss(diagnoses, exact=TRUE)

結果。

Fleiss' Kappa for m Raters (exact value)

Subjects = 30

Raters = 6

Kappa = 0.442

- Conger, A.J. (1980). Integration and generalisation of Kappas for multiple raters. Psychological Bulletin, 88, 322-328.

Fleiss' and category-wise Kappa

カテゴリごとのFleiss' kappaの値である。

kappam.fleiss(diagnoses, detail=TRUE)

結果。

Fleiss' Kappa for m Raters

Subjects = 30

Raters = 6

Kappa = 0.43

z = 17.7

p-value = 0

Kappa z p.value

1. Depression 0.245 5.192 0.000

2. Personality Disorder 0.245 5.192 0.000

3. Schizophrenia 0.520 11.031 0.000

4. Neurosis 0.471 9.994 0.000

5. Other 0.566 12.009 0.000