最も有名な一致係数である。扱うことができるのは名義尺度・順序尺度である。評価者が2名のものが基本だが、κ係数は3名以上に拡張されたバージョンも存在する。Cohenのκ係数というと評価者が2名の場合を指す。

κ係数の目安としてよく使われるのはLandis and Koch (1977)によって示されたものだろうか。

0.0〜0.2: わずかに一致(slight agreement)

0.21〜0.40 まずまずの一致(fair agreement)

0.41〜0.60 中等度の一致(moderate agreement)

0.61〜0.80 かなりの一致(substantial agreement)

0.81〜1.0 ほぼ完全、完全一致(almost perfect or perfect agreement)

Krippendorff (1980)にも基準が掲載されている。

0.67未満 評価しない(discounted)

0.67〜0.80 不確かな結果(conclusions tentatively)

0.80以上 明確な結果(definite conclusions)

Landis and Koch (1977) に比べて厳しい内容である。ともあれ、一致度は0.8以上が目安になるという内容である。

もちろん、この基準には根拠が明確にあるわけではないが、0.8という基準はよく使われている。また、論文などに記載するときには、一般的に認められている水準というような「これが私たちの常識だよ」的な記載がよく見られるが、これらの文献を引用した方が恰好がつくように思う。

CohenのκはSPSSで計算可能である。

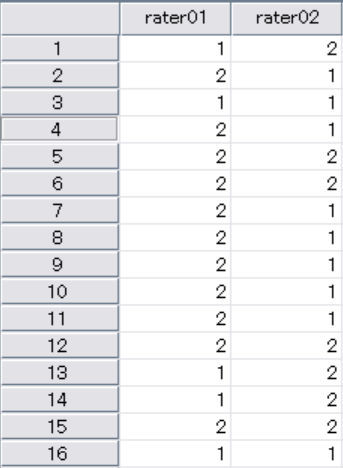

評価者を列、ケースを行のデータセットを作る。

[分析]→[クロス集計表]で、図のように行列を設定し、統計量の中の「カッパ」をチェックすると出力される。

なお、SPSSで計算できるのはノーマルなCohenのκで、重みづけκは出せない。

CohenのκはRのirrパッケージで計算ができる。irrパーッケージは重みづけκも計算ができるので必要がある場合は、Rを使うことになるだろう。

irrパッケージ

https://cran.r-project.org/web/packages/irr/index.html

https://cran.r-project.org/web/packages/irr/irr.pdf (pdf)

library(irr) # irrの読み込み

rater01<-c(1,2,1,2,1,1,2,2,1,2,1,1,1,2,1,2)

rater02<-c(2,2,2,1,1,1,2,1,1,1,2,1,2,2,2,2)

d1<-cbind(rater01, rater02)

kappa2(d1)

重みづけのオプションは"equal", "squared"の2つ。"unweighted"がデフォルト値で重みづけなしを意味している。

kappa2(d1, "squared")

equalはすべてのレベルで評価者間の不一致が均等に重み付けされ、squaredは不一致は完全一致からの自乗距離に応じて重み付けされる。

重みづけκの使用を検討するのは、評価が多段階である場合だ。

日本語で以下に解説がある。

http://www.med.osaka-u.ac.jp/pub/kid/clinicaljournalclub12.html

以下、数式を記載する。

κは次のように定義される。

ここでのは観察者の間で相対的に観察された一致度であり(正確度と同一)、

は観察されたデータを用いて各カテゴリーをランダムに観察者の確率を計算する仮説の確率一致である。

は、カテゴリーを

, 項目の数を

と

、評価者の数を

、予想されるカテゴリーを

とすると下記の数式となる。

文献

- Cohen, J. (1960). A coefficient of agreement for nominal scales. Educational and Psychological Measurement, 20, 37-46. http://citeseerx.ist.psu.edu/viewdoc/download?doi=10.1.1.1024.9753&rep=rep1&type=pdf

- Cohen, J. (1968). Weighted kappa: Nominal scale agreement with provision for scaled disagreement or partial credit. Psychological Bulletin, 70, 213-220. http://insights.ovid.com/psychological-bulletin/plbul/1968/10/000/weighted-kappa/1/00006823

- Krippendorff, K. Content analysis: An introduction to its methodology. Sage Publications; Beverly Hills, CA: 1980.

- Landis JR, Koch GG. The measurement of observer agreement for categorical data. Biometrics. 1977; 33(1):159-174. https://www.ncbi.nlm.nih.gov/pubmed/843571